xiaver初始化器及神经网络优化算法

1.xiaver初始化器

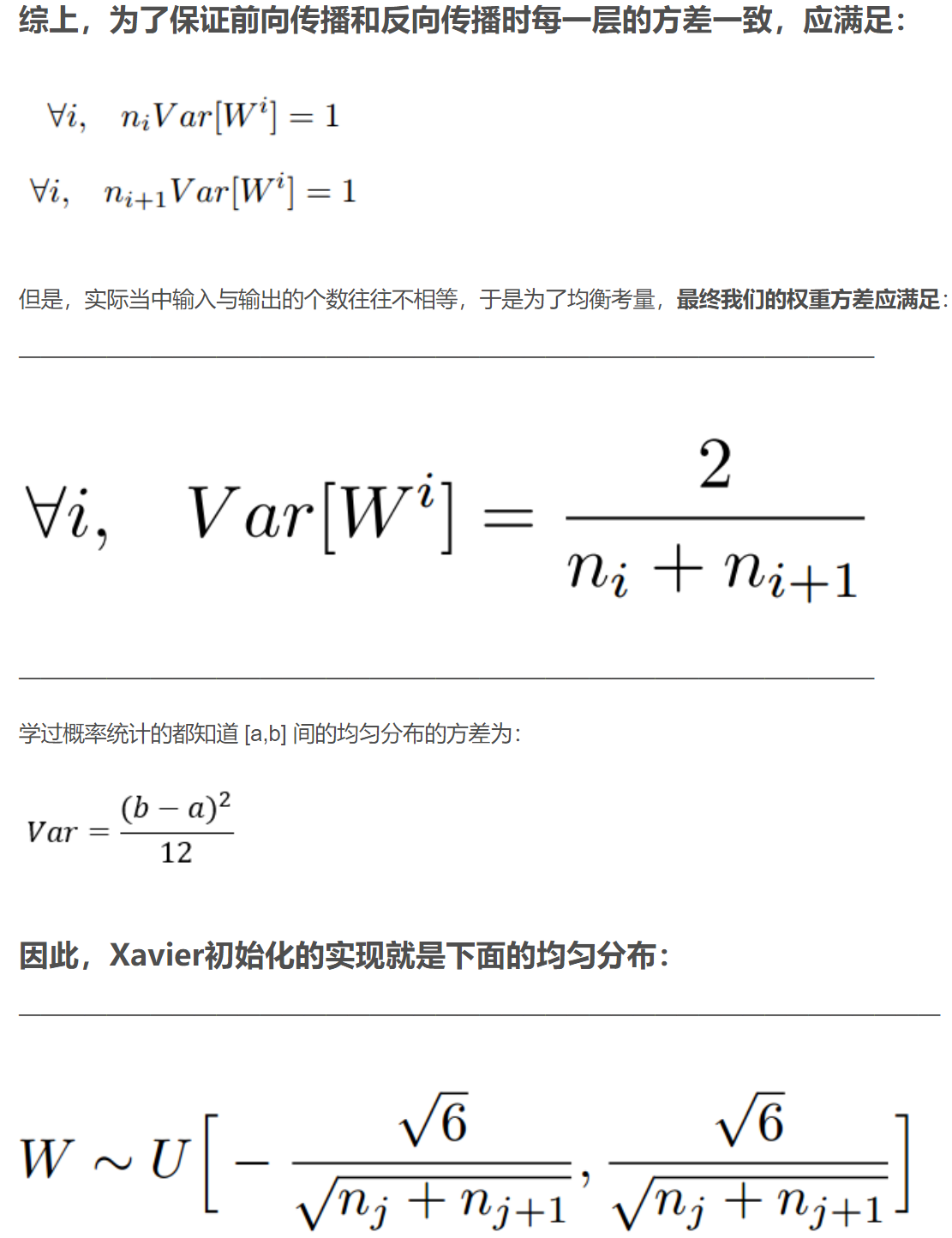

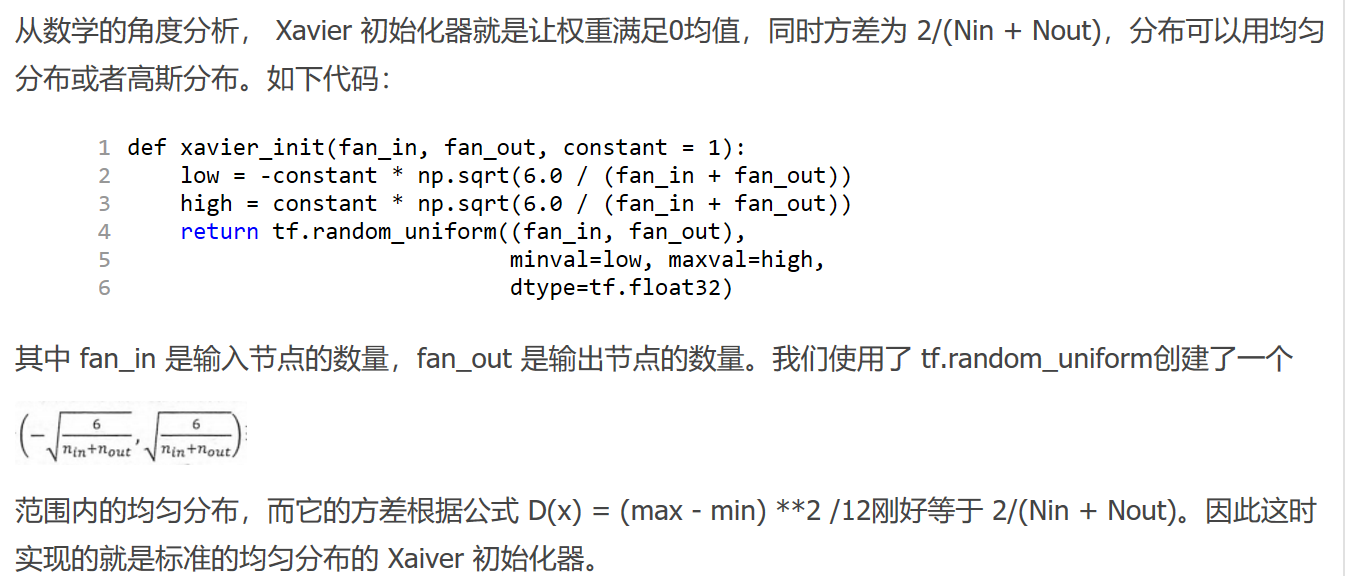

如果深度学习模型的权重初始化的太小,那信号将在每层间传递时逐渐缩小而难以产生作用,但如果权重初始化的太大,那信号将在每层间传递时逐渐放大并导致发散和实效。而 Xavier 初始化器做的事情就是让权重被初始化的不大不小,正好合适。

具体xiaver初始化原理:

https://blog.csdn.net/shuzfan/article/details/51338178

2.神经网络优化算法

机器学习界有一群炼丹师,他们每天的日常是:

拿来药材(数据),架起八卦炉(模型),点着六味真火(优化算法),就摇着蒲扇等着丹药出炉了。不过,当过厨子的都知道,同样的食材,同样的菜谱,但火候不一样了,这出来的口味可是千差万别。火小了夹生,火大了易糊,火不匀则半生半糊。

机器学习也是一样,模型优化算法的选择直接关系到最终模型的性能。有时候效果不好,未必是特征的问题或者模型设计的问题,很可能就是优化算法的问题。

深度学习优化算法经历了 SGD -> SGDM -> NAG ->AdaGrad -> AdaDelta -> Adam -> Nadam 这样的发展历程。

各优化算法的特性可见以下链接:

https://zhuanlan.zhihu.com/p/32230623

本文章使用limfx的vscode插件快速发布